支持 Windows、MacOS, 本地部署 Llama3.1 最强开源大模型!可离线使用!

warning:

这篇文章距离上次修改已过305天,其中的内容可能已经有所变动。

在开始之前,首先我们需要安装Ollama客户端,来进行本地部署Llama3.1大模型

1.本地电脑安装的硬件要求:

Windows:3060以上显卡+8G以上显存+16G内存,硬盘空间至少20G

Mac:M1或M2芯片 16G内存,20G以上硬盘空间

官方下载:【点击前往】

安装命令:

安装llama3.1-8b,至少需要8G的显存,安装命令就是

ollama run llama3.1:8b安装llama3.1-70b,至少需要大约 70-75 GB 显存,适合企业用户,安装命令就是

ollama run llama3.1:78b安装llama3.1-405b,这是一个极其庞大的模型,安装和运行它在本地需要非常高的显存和硬件资源,至少需要大约 400-450 GB 显存,适合顶级大企业用户,安装命令就是

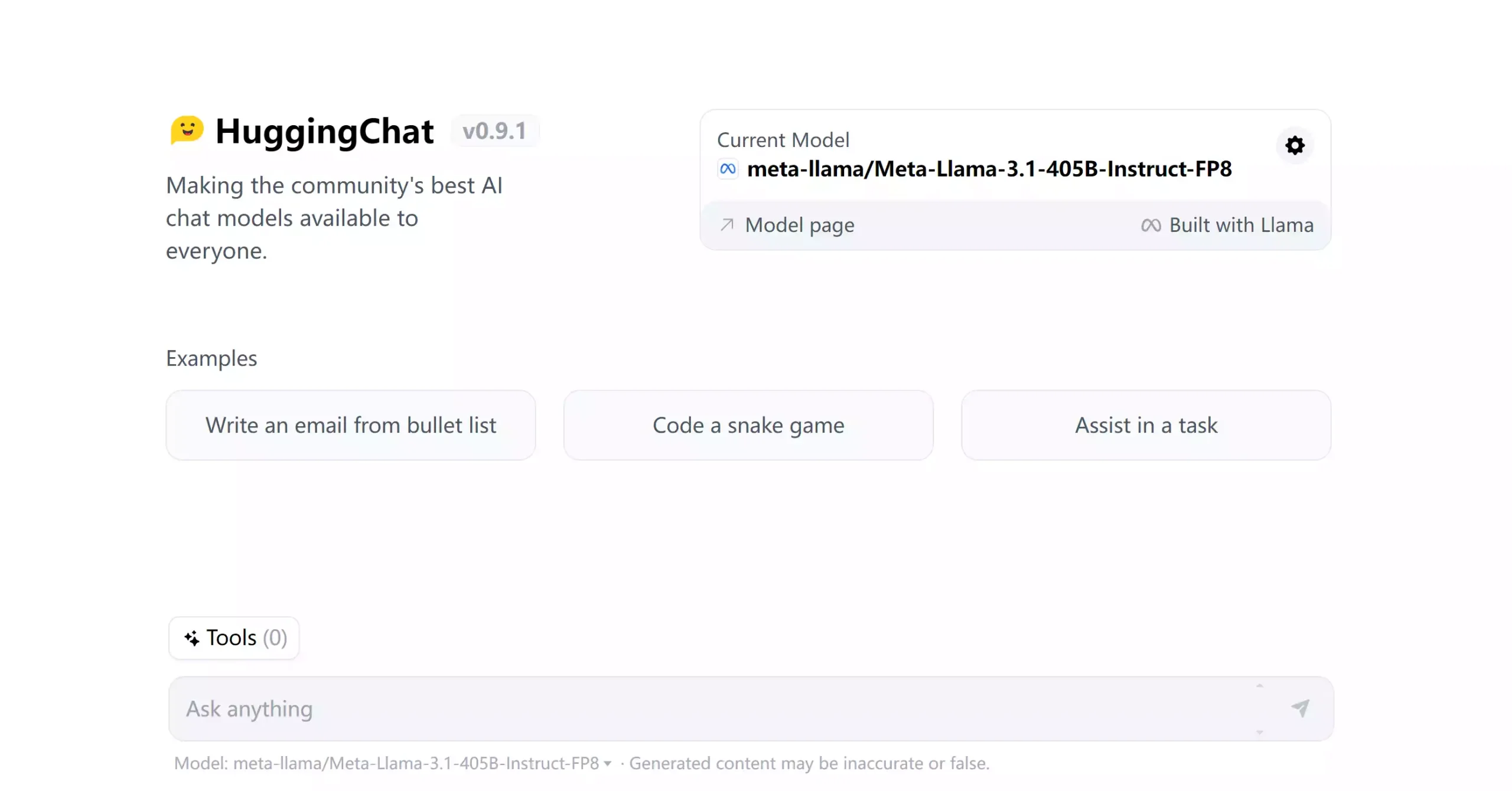

ollama run llama3.1:405b2.如果你没有可运行的显卡,那么可以在Huggingface平台上使用,因为huggingFace 上已经托管了Llama3.1大模型,现在完全免费使用!

【链接直达】